Штучний інтелект і ТікТок: як відомих журналісток перетворюють на фейки

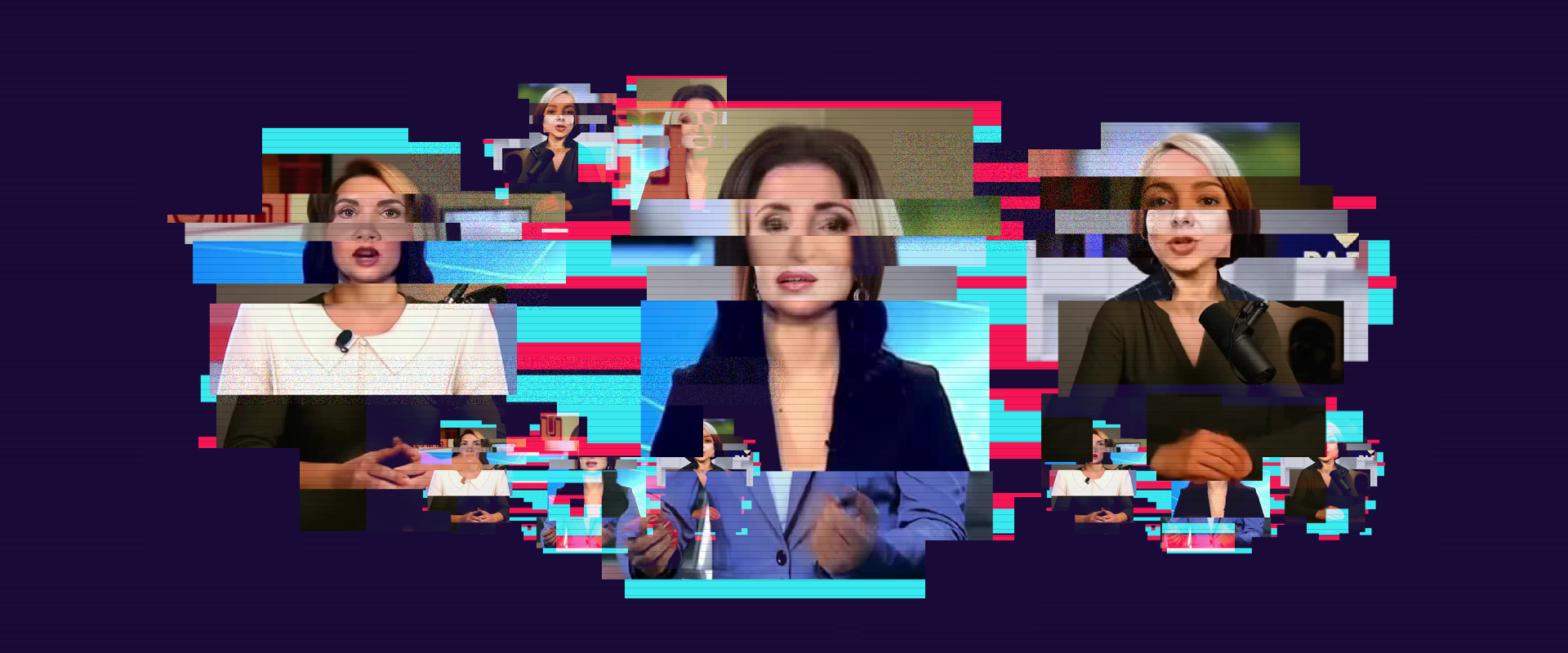

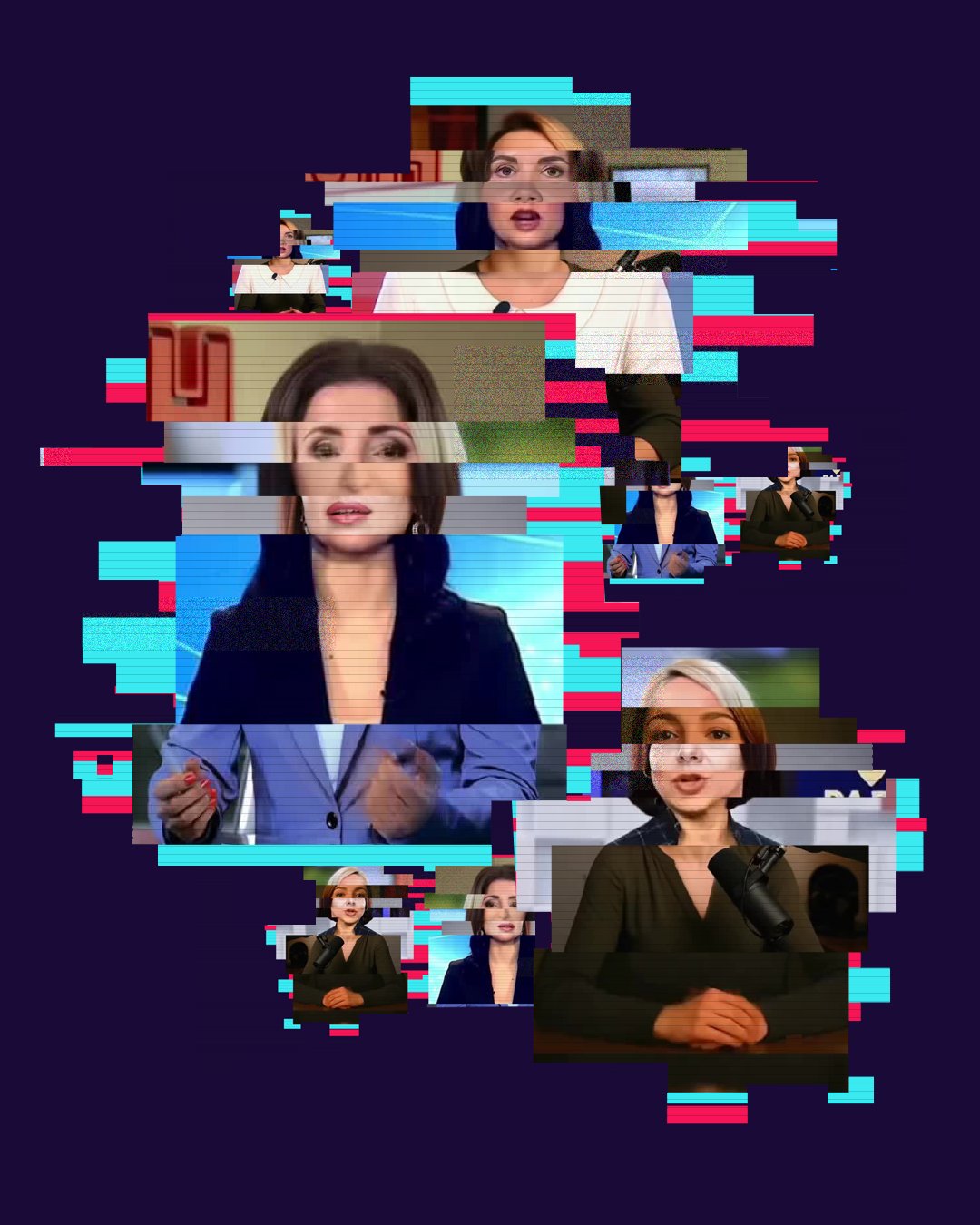

Вкрасти чиєсь обличчя, тіло, голос і створити згенеровану ШІ копію людини, яка говоритиме й рухатиметься так, як захоче її «творець», легко.

увімкнути звук ⟶

Read in English

Фейкове відео зі справжньою ведучою

Перед вами зараз фальшива ведуча ютуб-каналу Texty.org.ua Валерія Павленко. Далі ми розповімо, що пропагують згенеровані ШІ клони журналісток і як їх відрізнити від реальних людей.

Ми проаналізували 595 відео, згенерованих зловмисниками за допомогою ШІ, де використовувався образ відомих жінок. Загалом у ТікТоці ці ролики набрали понад 24 млн переглядів. Кількість переглядів і реакцій користувачів соцмережі на деякі з них вражає.

Коротко про розслідування

У 2008 році на телеканалі «1+1» розпочався кар’єрний шлях Соломії Вітвіцької — спершу як кореспондентки ТСН, а згодом як ведучої. Сьогодні Вітвіцька — одне з найвідоміших облич телеканалу «1+1».

Та для нас стало несподіванкою, що образ телеведучої активно використовують у ТікТоці й далеко не завжди з добрими намірами. Ми виявили 100 відео, у яких віртуальна Вітвіцька говорить і діє завдяки алгоритмам штучного інтелекту. У деяких роликах її голос згенеровано, в інших створено повністю фейкові сюжети із синтетичною мімікою, інтонацією та неправдивими повідомленнями.

І це не поодинокі випадки. Українські журналістки дедалі частіше стають «цифровими аватарами» — не з власної волі, а через бажання маніпуляторів використати довіру до них як інструмент впливу. Те, що ще кілька років тому здавалося технологічною цікавинкою, сьогодні перетворюється на форму онлайн-насильства. А штучний інтелект став знаряддям дискредитації та дезінформації.

Ми вирішили розібратися, як у ТікТоці використовують штучний інтелект для створення чи спотворення відео з образами журналістів. Наш фокус — журналістки, які у відсотковому виразі становлять більшість у медіагалузі України.

У процесі аналізу ми натрапили на десятки роликів, де їхній голос, зовнішність або стиль мовлення були штучно змінені чи повністю згенеровані. Ми дослідили, які саме ШІ-технології використовуються, про що ці відео і яку мету ставлять перед собою ті, хто стоїть за ними.

У роликах використовуються різні технології штучного інтелекту — від синтезу голосу і накладання його на реальне зображення до повноцінних дипфейків зі згенерованими і зображенням, і звуком.

Переважна частина контенту в нашій вибірці мала ознаки аудіовтручання. Інакше кажучи, реальні новинні сюжети були озвучені новими голосами, створеними для просування певного меседжу, сюжету чи наративу. Подеколи голос штучно моделювався під відомих українських телеведучих, і це посилювало ефект достовірності.

Такі аудіоманіпуляції часто видають самі себе. Неприродна вимова, неправильні наголоси, дивні паузи і рваний ритм мови — усе це ознаки машинної генерації.

Ми промаркували 328 тікток-відео з аудіоманіпуляціями і ще 267 відео, де штучний інтелект використовувався для створення чи зміни і зображення, і голосу.

Збір та обробка даних. Із 1 серпня по 30 вересня ми шукали відео в ТікТоці, у яких присутні жінки-журналістки.

Для збору даних ми використали техніку снігової кулі. Спочатку пошук відео здійснювали переважно за хештегами #журналіст, #журналістка, #ведуча, #тсн, #інтер, але в процесі знаходили контент із додатковими хештегами й поступово розширювали їх набір. Із кінцевим списком використаних під час пошуку хештегів ви можете ознайомитися за цим посиланням.

Зі знайдених відео ми відібрали ті, де є елементи ШІ-генерації (аудіо чи відео) або ШІ-модифікації.

Дати публікації відео з нашого набору охоплюють період із 2023 по 2025 рік. Найстаріше відео було опубліковане в жовтні 2023-го, а найновіше 17 вересня 2025-го.

Необхідну інформацію ми зберігали за допомогою тікток-скреперів, написаних мовою Python: завантажували відео, ID відео, назву й опис, ім’я користувача, час публікації, кількість лайків та коментарів.

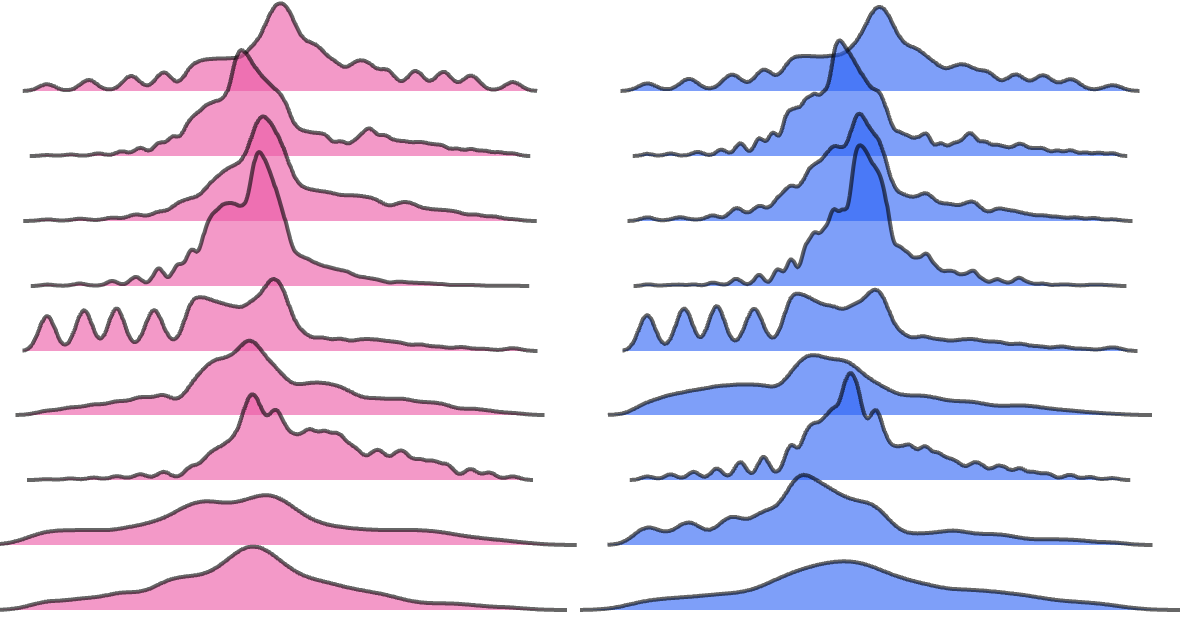

Для перевірки аудіо на предмет ШІ-генерації ми використовували розширення для браузера (Chrome) Hiya Deepfake Voice Detector, яке аналізує голос. Позначали голос як фейковий, якщо інструмент фіксував понад 50% імовірності несправжньої аудіодоріжки.

Окрім автоматизованої перевірки ми провели ручну валідацію результатів. У процесі такої перевірки додатково підтверджувалася наявність ШІ-втручання у відео, а матеріали групувалися за визначеними категоріями: тип основного ШІ-втручання (голос / відео); тематика відео; журналістка, образ якої використовувався у відео.

Натхненням для візуальної частини нашого матеріалу став проєкт Bloomberg «The Second Trump Presidency, Brought to You by YouTubers».

Обмеження методології

ТікТок обмежує доступ до повних даних, що впливає на повноту вибірки.

Пошук відео з використанням техніки снігової кулі не дає змоги охопити весь обсяг матеріалів. Він обмежується чітко визначеними хештегами і не враховує релевантні відео, позначені хештегами, які не були використані в процесі пошуку.

Використані інструменти валідації, зокрема інструменти для визначення ШІ-втручання (у нашому випадку Hiya Deepfake Voice Detector), можуть давати похибки або хибні результати. Тому ми додатково застосували ручну перевірку отриманих результатів.

Експлуатація образу

Творці ШІ-контенту часто експлуатують образи відомих українських журналісток і телеведучих. Це прорахована стратегія.

По-перше, журналісти асоціюються з довірою. Оскільки довіра до повідомлення залежить від того, хто його транслює, використання їхнього образу має на меті пробити стіну недовіри.

По-друге, впізнавані обличчя збільшують перегляди і поширюваність контенту: користувачі швидше реагують на відомих медійних персон, особливо тих, кого часто бачать по ТБ чи на Ютубі.

По-третє, маніпулятори свідомо обирають жіночі образи. Журналістки часто асоціюються з емпатією, турботою або чесністю — ці якості збільшують довіру до повідомлення навіть тоді, коли воно створене алгоритмом.

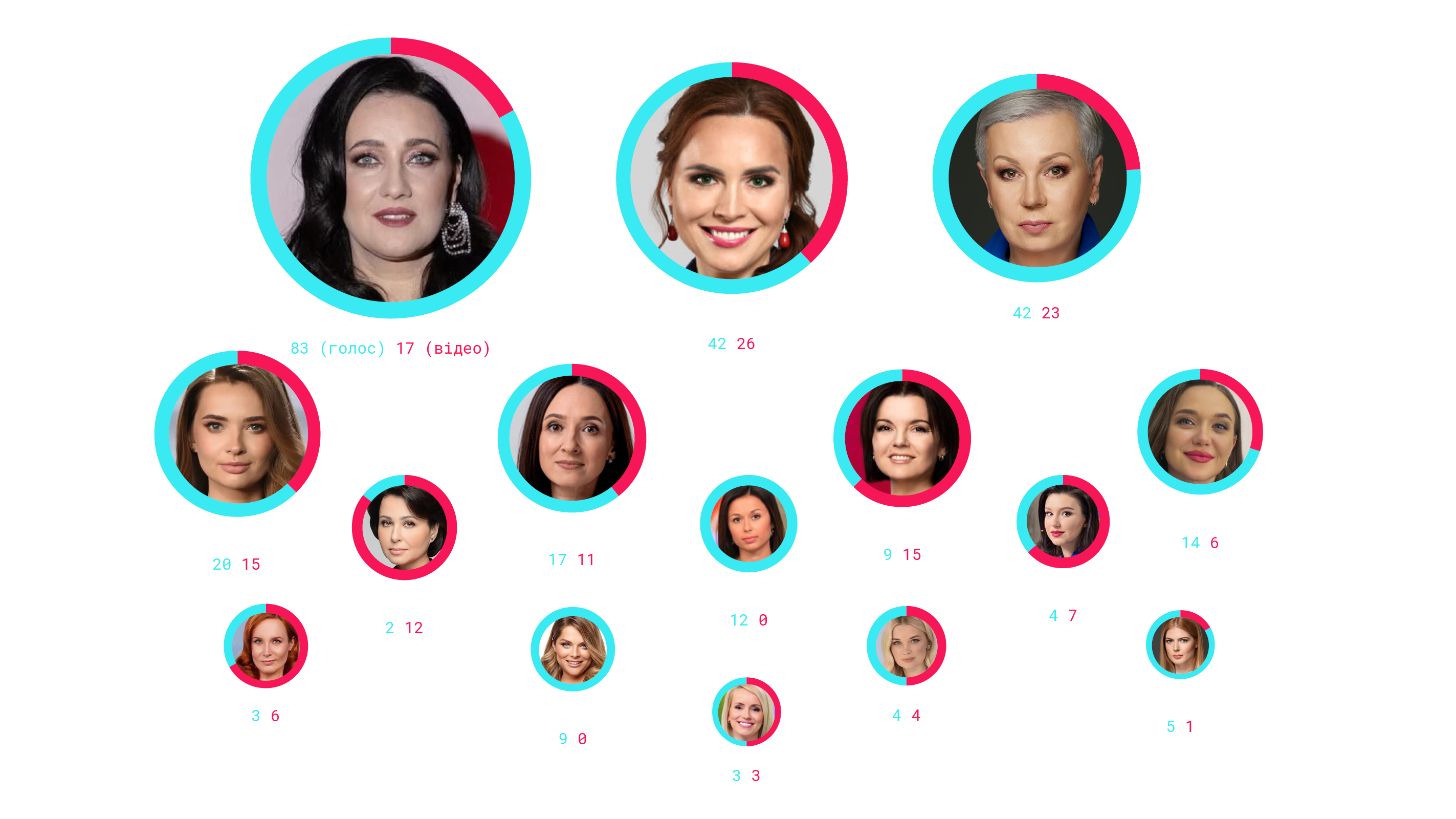

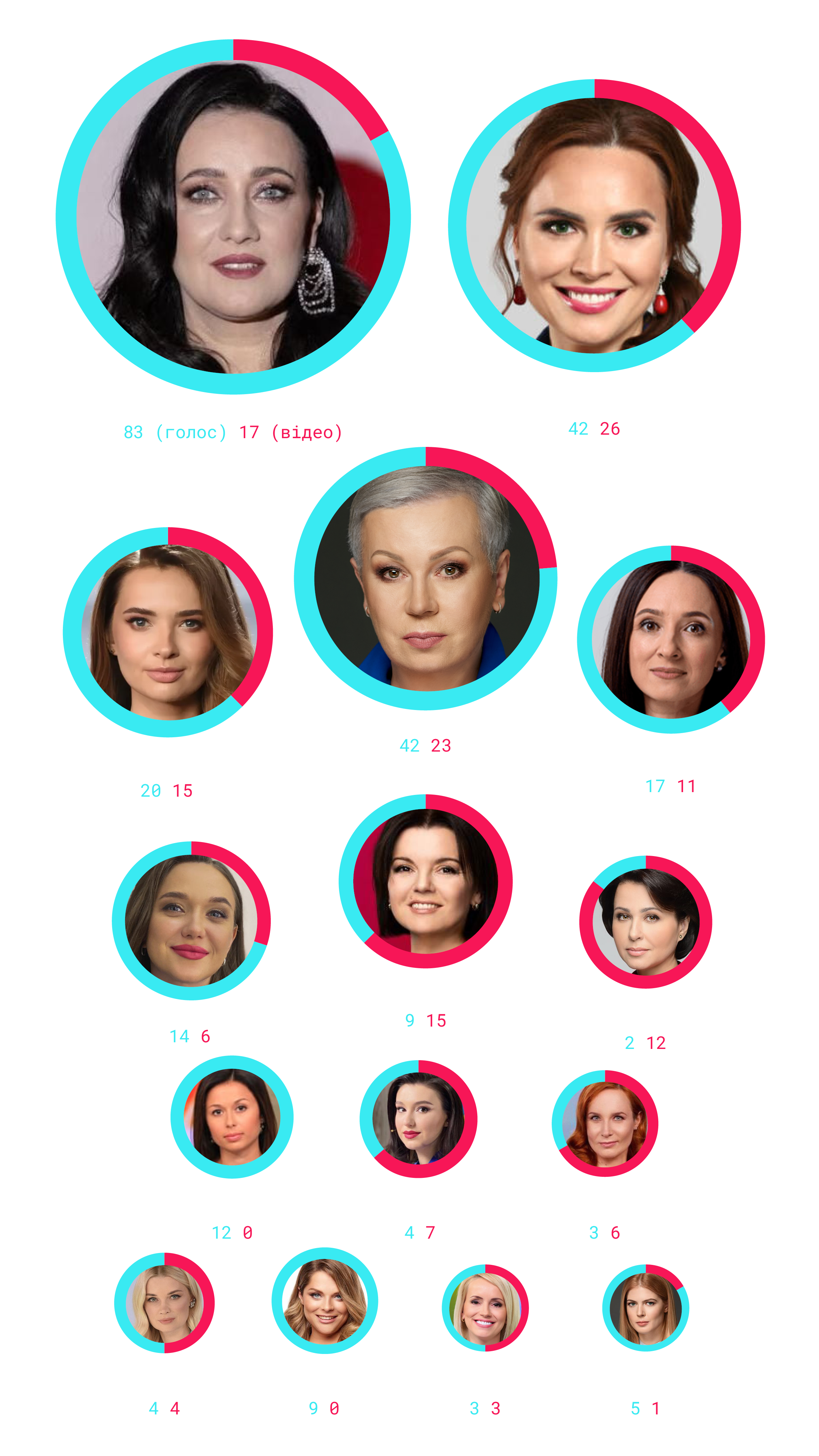

Серед журналісток, чиї образи використовуються найактивніше, Соломія Вітвіцька з «1+1» (17 відеогенерацій і 83 аудіоманіпуляції), Анастасія Даугуле з телеканалу «Інтер» (26 відеогенерацій і 42 аудіоманіпуляції) та Алла Мазур з «1+1» (13 відеогенерацій і 42 аудіоманіпуляції).

Найпопулярніші ведучі, образ яких використовують у фейкових відео

Згадані випадки мають усі ознаки технологічно й гендерно зумовленого насильства (Technology-facilitated gender-based violence, TFGBV).

Використання образу жінки-журналістки без її згоди

Відео маніпулятивно створене за допомогою ШІ з використанням обличчя й голосу журналісток. Це форма обману, що принижує професійну репутацію і створює додаткові ризики для безпеки.

Гендерна вразливість і дискредитація

Жінки-журналістки часто стають мішенню для таких шахраїв саме тому, що мають високу публічність і довіру аудиторії. Використання жіночого образу підсилює ефект довіри, але водночас дискредитує її як особистість і як професіонала. Це елемент гендерної дискримінації: атакують не просто журналіста, а саме жінку в медіа.

Цифрове насильство і вторгнення в приватність

Нав’язування фейкового контенту від імені журналістки — це форма онлайн-насильства, що може призвести до втрати довіри аудиторії, погроз у соцмережах чи вторинної віктимізації. Журналістка втрачає контроль над своїм образом, який перетворюють на інструмент шахрайства.

Ширший вплив на інших жінок

Такі випадки створюють «охолоджувальний ефект» (chilling effect) для інших журналісток: вони бачать, що можуть стати наступними жертвами дипфейк-маніпуляцій, і це посилює страх, самоцензуру й призводить до відмови від активної участі в публічному житті.

Джерело тут.

Загалом відео з нашого набору даних набрали понад 24 млн переглядів. Кількість переглядів і реакцій користувачів соцмережі на деякі ролики вражає.

Найпопулярніші фейкові відео

Наприклад, 17 травня профіль користувача coaxinyxhzq розмістив відео "#петиція #новиниукраїни #закони #українапонадусе💙💛". Станом на 15 жовтня відео вже видалене. Однак на момент його фіксації воно набрало майже 670 тис. переглядів, понад 28,5 тис. лайків, 2153 репости та понад 1,6 тис. коментарів.

На відео фейкова Алла Мазур розповідає, що можна підписати ініціативу, яка підтримує пропозицію нардепа Олексія Гончаренка про мобілізацію 500 тис. поліцейських замість простих цивільних.

Відео з фейковою Наталією Мосейчук у профілі користувача tsn11ua2, опубліковане 27 травня 2025 року, набрало 517 тис. переглядів, понад 7,7 тис. лайків, 226 репостів і 258 коментарів. У ньому йдеться про нову петицію, у якій пропонується замість «простих українців» посилати на фронт працівників ТЦК і поліції.

А опублікований 10 травня 2025 року на каналі ukr_news52 відеосюжет із Аллою Мазур і згенерованим ШІ голосом про умови закінчення війни набрав понад 415 тис. переглядів і 2381 репост.

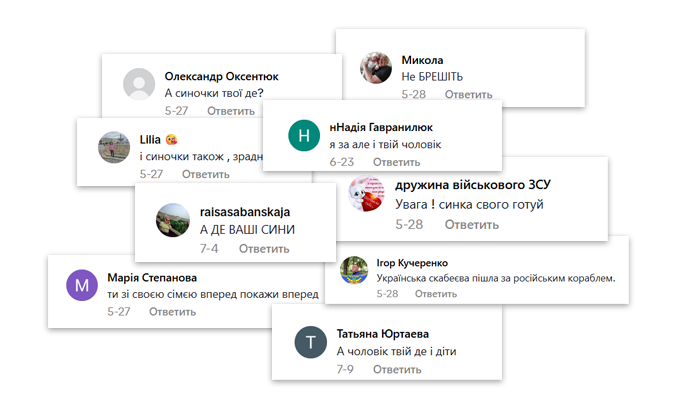

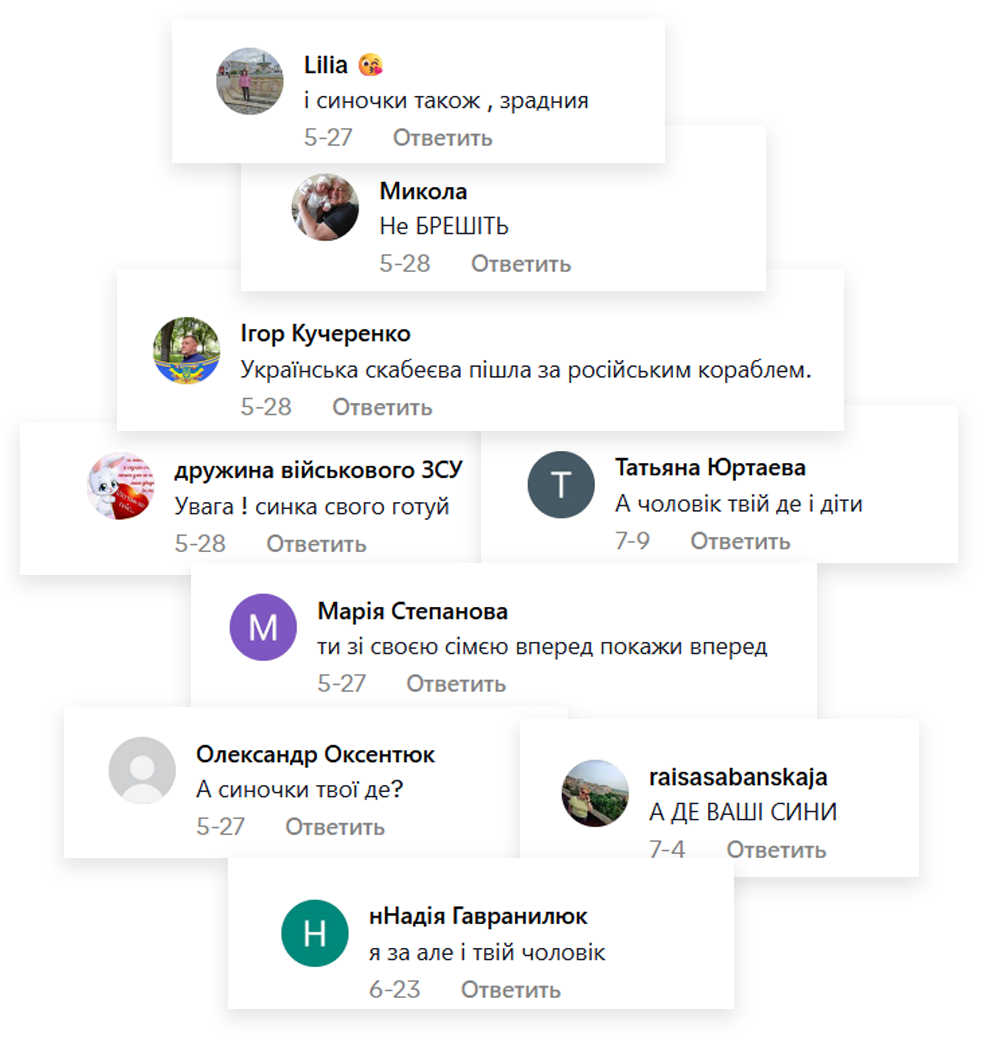

Такий контент впливає на репутацію журналістки, сприйняття її аудиторією. Люди часто плутають реальну людину з її шахрайською копією і починають хейтити за те, що говорить ця копія.

Так, користувачі, які переглянули згадане вище відео з фейковою Мосейчук, писали, що вона зрадниця, ховає своїх дітей і чоловіка від мобілізації.

Такі коментарі можуть бути також частиною цілеспрямованої дискредитаційної кампанії і можуть належати не реальним користувачам.

Коментарі на фейкове відео

Варто зазначити, що ті, хто експлуатує образи популярних телеведучих, водночас копіюють і відомі медіабренди. У назвах тікток-акаунтів, через які просувалися фейкові журналісти, часто з’являлися елементи, що асоціювалися з легітимними новинними джерелами. Наприклад, частка «tsn» фігурувала щонайменше в 15 акаунтах: tsn.news.ua1, tsn_.news11, tsn.news.24.7, tsn1.news тощо. Така імітація мала створити додаткову ілюзію довіри до поширювачів відеоконтенту.

Що просувають фейкові журналістки

Образи журналісток використовують із різною метою — від поширення антиукраїнських і деструктивних наративів до закликів підписатися на канали. Ми виокремили кілька основних груп.

Найпоширеніші теми фейкових відео

268

145

116

22

18

26

Яскравим свідченням того, наскільки створення цифрових аватарів проникає в наше життя, є відкрита реклама відповідних технологій.

У тікток-акаунті garant_konstitucy дипфейки стали товаром: тут пропонують замовити штучно згенероване привітання або розіграш. За додаткову плату автор готовий навчити клієнтів «робити якісні дипфейки».

Відео на каналі містять попередження, що це дипфейк. Проте залишається питання: чи отримали автори згоду на використання образів популярних телеведучих?

Та найчастіше автори відео намагаються приховати факт ШІ-генерації.

Найбільша кількість відео в нашому наборі містить заклик підписати петицію чи пройти опитування — 268 (45%). Наприклад, «популярні телеведучі» розповідають про те, що з’явилася петиція, яка:

- поверне Залужного на посаду головнокомандувача;

- приведе до відставки Зеленського або зробить президентом проросійського політика Євгена Мураєва;

- відправить усіх поліцейських і працівників ТЦК на фронт;

- допоможе конфіскувати майно топпосадовців чи Юлії Тимошенко;

- змусить Мар’яну Безуглу йти воювати на нуль.

На перший погляд, ці повідомлення можуть здаватися випадковими. Проте їх структура чітко повторює звичні тактики російської дезінформації: апеляція до емоцій, розпалювання суперечок і підрив довіри до держави.

Наприклад, питання про можливе повернення Валерія Залужного на посаду головнокомандувача хоч і не має під собою реальних підстав, але провокує суперечки й сильні емоції. Просування Євгена Мураєва очікуване: це фігура, яку російські медіа вже не раз намагалися легітимізувати.

Інша теза — про відправлення всіх поліцейських на фронт — також звучить нереалістично. Проте вона активно транслюється джерелами, що поширюють російські наративи в Україні, й, на жаль, знаходить відгук у частини суспільства.

Ще один інструмент для посилення суспільної поляризації, що покликаний відокремити державу від громадян, — ідея конфіскації майна високопосадовців.

У таких роликах автори закликають перейти за посиланням, підтримати ініціативу або долучитися до голосування. На практиці це означає лише одне: користувач переходить на сторонні ресурси, підписується на фейкові акаунти або, що ще гірше, передає свої персональні дані зловмисникам.

Фейкові відео із закликами підписати петицію чи пройти опитування

13.05.2025

Канал: ukrnews_today

Петиція щодо мобілізації поліцейських

Кількість переглядів: 64 600

15.07.2025

Канал: interesting_petitions_ua

Петиція щодо відправки працівників ТЦК на фронт

Кількість переглядів: 352 900

08.05.2025

Канал: news_ua_tsn

Петиція щодо скасування премій працівникам ТЦК і поліції за мобілізованих

Кількість переглядів: 270 100

15.05.2025

Канал: online__petition

Петиція щодо відставки Стефанчука

Кількість переглядів: 129 200

07.04.2025

Канал: news.in.ua2025

Петиція щодо зняття Сирського та повернення на посаду головнокомандувача Залужного

Кількість переглядів: 1567

Майже кожне четверте знайдене нами відео з ШІ-втручанням експлуатує образи журналісток із метою отримати дані користувачів і збільшити аудиторію своїх ресурсів за допомогою фейків про соціальну допомогу. Ми виявили 145 таких сюжетів (24%).

Фейкові Наталія Островська та Ірина Прокоф’єва (ведучі телеканалу «1+1») розповідають, що українці можуть отримати надбавки, пенсії чи виплати, якщо заповнять відповідні форми. Звернення часто таргетуються на певні категорії: пенсіонери, батьки, вчителі, ті, хто залишився в країні після початку повномасштабного вторгнення. Виплати нібито здійснюють різні структури — від ООН, Товариства Червоного Хреста, ЄС, Канади та США до державних банків, особисто президента й мереж магазинів «Аврора» і «MOYO».

Фейкові відео про соціальну допомогу

15.05.2025

Канал: ukrnews_today

Отримати кошти, конфісковані в «головнокомандувача ТЦК»

Кількість переглядів: 15 000

12.03.2025

Канал: maratcppl9g

Отримати кошти від ООН

Кількість переглядів: 11 800

29.12.2024

Канал: gymanitarka.ua

Отримати гуманітарну допомогу

Кількість переглядів: 3543

16.03.2025

Канал: newsnow673

Отримати допомогу від Червоного Хреста

Кількість переглядів: 2238

01.04.2025

Канал: maratcppl9g

Отримати кошти від ООН

Кількість переглядів: 3905

Майже 20% відео (116) містить деструктивні або антиукраїнські наративи. Найчастіше це контент про жахи мобілізації, незаконні дії правоохоронців, дискредитацію влади та військово-політичного керівництва. У таких роликах розповідають, що сусіди України нібито планують окупувати західні області або що мир настане вже найближчим часом — варто лише підписатися на соцмережі, щоб дізнатися дату.

Спекуляції на поточних подіях поширюються миттєво. Наприклад, 19 липня 2024 року було вбито політичну та громадську діячку Ірину Фаріон, і вже за кілька днів згенеровані ШІ голоси, накладені на реальні журналістські сюжети, розганяли в ТікТоці фейки про те, що вбивця був родичем Фаріон, що затримали не того і що є реальні кадри трагедії.

Фейкові відео з деструктивними наративами

07.05.2025

Канал: terminovinews8

Нові правила мобілізації

Кількість переглядів: 324 200

29.05.2025

Канал: news_0f_ukra1ne

Чоловіків змусять повернутися з-за кордону

Кількість переглядів: 234 600

06.05.2025

Канал: newsukr93

ТЦК дістали більше повноважень

Кількість переглядів: 148 300

23.05.2025

Канал: tsn11ua2

Просування росіян у Дніпропетровській області

Кількість переглядів: 62 900

15.05.2025

Канал: ukrnews_today

Починаються перемовини між Путіним і Зеленським

Кількість переглядів: 16 000

Як розрізняти справжні та фейкові відео

Експерт із OSINT Генк ван Есс зазначає: «Гонка озброєнь між творцями ШІ й детекторами триває, і наразі перевага за швидкістю на боці творців. Визначення, що є дипфейком, а що ні, перетворюється на гру в котика й мишку, і розробники постійно вдосконалюють технологію».

Під час перевірки варто звертати увагу на тривожні сигнали, особливо якщо ідентифікацію потрібно здійснити у швидкому темпі.

Перевірка на бездоганність. Чи в людини не надто елегантний, ідеальний для конкретної ситуації вигляд?

Перевірка шкіри. Чи в людини не надто гладка шкіра? Чи помітна ретуш там, де мала б бути природна текстура? Чи є пори та незначні асиметрії?

Загальна оцінка зовнішнього вигляду. Чи відповідає зовнішній вигляд людини сценарію?

Оцінка одягу. Чи є на одязі природні складки, сліди зносу?

Оцінка волосся. Чи видно окремі волосинки? Чи волосся, навпаки, схоже на намальоване / глянцеве?

Оцінка ювелірних виробів та аксесуарів. Аксесуари тривимірні чи пласкі, як на комп’ютерній графіці?

Огляд зубів. Чи помітні природні недосконалості? Чи, навпаки, зуби на вигляд ідеальні та однорідні?

Щодо голосу та аудіопереробок. Технологія клонування голосу дає змогу відтворити голос будь-якої людини, маючи лише кілька секунд аудіозапису. Однак залишаються помітні сліди штучного походження: у мовних патернах, емоційній достовірності та акустичних характеристиках.

Попри вражаючу точність, синтетичні голоси все ще не здатні передати ті тонкі особливості людської інтонації, які роблять мовлення по-справжньому автентичним.

Типові ознаки штучного походження голосу:

- неприродна артикуляція;

- бездоганна вимова без властивих людській мові недоліків;

- роботизована інтонація окремих слів чи фраз;

- відсутність природного фонового шуму;

- фрази чи терміни, які в реальному житті людина навряд чи використовувала б.

Зробімо поверховий аналіз на наявність ШІ-генерації одного відео з нашого набору.

Основою для дипфейку, найімовірніше, став образ Соломії Вітвіцької. У відео розповідається про появу нової петиції, яка нібито зобов’язує мобілізувати політиків і чиновників.

Проте одразу ж стає зрозуміло, що це фейк: достатньо уважно придивитися до рук «ведучої». Зокрема, на 1-й секунді видно, як із лівої руки зникає блокнот.

На 3-й секунді погляд «ведучої» неприродно спрямований кудись убік, а не на камеру. Крім того, знизу тека (планшет) відблискує, створюючи аномальну тінь.

Можна помітити, що волосся «ведучої» рухається неприродно: у різних фрагментах відео окремі пасма то з’являються, то зникають.

На 17-й секунді «ведуча» неприродно вигинає спину, що типово для дипфейк-генерації. Також можна помітити характерну для ШІ-генерації артикуляцію.

На 21-й секунді бачимо, що освітлення на обличчі не завжди узгоджується з освітленням на задньому плані. Обличчя «ведучої» здається надто гладеньким, особливо в ділянці чола та брів, текстура шкіри неприродна.

Як розпізнати фейк

У відео «ведуча» весь час неприродно рухає руками. На кількох кадрах видно, що очі не фокусуються на камері, а ніби «висять» у просторі. Тло здається штучним. Аудіодоріжка також має ознаки штучної генерації: роботизована інтонація, неправильні наголоси і паузи, подеколи невідповідність між вимовленими словами й артикуляцією.

Варто зазначити, що оцінювати треба не лише аудіовізуальну складову, а й зміст повідомлень. Фрази на кшталт «усі мовчать, що…», «українці, а ви це чули…», лексика з елементами протиставлення «ми — вони» або «прості українці — влада», брак конкретики («відомий лікар без імені зробив гучну заяву»), а також відсутність посилань на джерела («більшість українців не знали про це») — усе це типовi прийоми маніпуляції, спрямовані на те, щоб викликати емоційну реакцію й утримати увагу глядача.

Замість висновків

Громадська організація «Жінки в медіа» у своєму новому дослідженні зазначає, що випадки використання ШІ-технологій для здійснення онлайн-атак на журналісток поки що не є масовими. Втім, такі інциденти вже фіксуються, і з розвитком технологій їх масштаби можуть стрімко зростати.

Опитування серед журналісток засвідчило: зі 119 респонденток кожна 15-та (7%) уже стикалася з онлайн-атаками, створеними за допомогою ШІ, ще 16% спостерігали такі атаки на своїх колег. Мішенями найчастіше стають журналістки та керівниці медіа як публічні представниці редакцій.

Крім того, 43% респонденток повідомили, що бачать згенерований ШІ контент щонайменше раз на тиждень. Це свідчить про те, що таких матеріалів у медійному середовищі стає дедалі більше.

Що показало наше дослідження

Цифрові аватари стають інструментом онлайн-насильства. ШІ дає змогу створювати реалістичні копії журналісток, які можуть казати чи робити те, чого ніколи не було, підриваючи їхню репутацію та безпеку.

Репутаційні та психологічні наслідки масштабні. Відео з фейковими голосами й обличчями журналісток провокують кібербулінг, онлайн-хейтинг і створюють «охолоджувальний ефект» для інших жінок у медіа.

ШІ пришвидшує дезінформацію. Завдяки алгоритмам ТікТоку згенеровані ШІ відео швидко набирають мільйони переглядів, що, по суті, унеможливлює перевірку та протидію фейкам.

Нова форма цифрового насильства. Викрадення образу і голосу журналісток — інструмент свідомої маніпуляції, що поєднує онлайн-насильство, дискредитацію та потенційні ризики для національної безпеки.

ТікТок формально зобов’язався забезпечити прозорість контенту, створеного чи істотно зміненого штучним інтелектом. Політики платформи вимагають чіткого маркування таких відео та зображень або користувачем, або автоматично через систему Content Credentials. Теоретично це має запобігати поширенню синтетичного контенту. Також заборонено створювати контент, що імітує реальних осіб без їхньої згоди, вводить в оману або поширює дезінформацію.

Проте на практиці ці правила нерідко порушуються. Наше дослідження засвідчило, що численні згенеровані ШІ відео з реальними журналістками публікувалися без належного маркування, подеколи містили дезінформацію чи образи. Політики ТікТоку часто ігноруються, що ставить під сумнів ефективність захисту користувачів від синтетичного контенту та координованої неавтентичної поведінки.

Хоча ТікТок інвестує в технології виявлення та інформування користувачів, розрив між політикою та реальністю свідчить про те, що обіцянки забезпечити прозорість залишаються радше декларативними.

На основі нашого дослідження, а також на основі Керівних принципів регулювання цифрових платформ, розроблених ЮНЕСКО, ми підготували низку рекомендацій.

Для урядів і державних установ

- Розробляти національні стратегії регулювання цифрових платформ із урахуванням локальних та міжнародних норм.

- Забезпечувати баланс між саморегулюванням, спільним регулюванням і статутним регулюванням, щоб комплексно охоплювати різні аспекти цифрового середовища.

- Передбачати участь усіх ключових зацікавлених сторін: держави, платформ, громадянського суспільства, медіа, науковців і незалежних експертів.

- Встановити вимоги до платформ щодо прозорого звітування про модерацію та видалення контенту, а також щодо дотримання прав людини.

- Вимагати від платформ створення легкодоступних систем повідомлення про порушення своїх політик і прав людини з особливою увагою до дітей і вразливих груп.

Для користувачів

- Використовувати інструменти платформи для регулювання пропонованого контенту та персоналізації рекомендацій.

- Критично оцінювати інформацію і джерела, перевіряти надійність матеріалів.

- Знати свої права на платформі й користуватися механізмами апеляції, якщо контент був обмежений чи видалений.

- Повідомляти про порушення політик платформи через доступні канали скарг.

- Вчитися критично сприймати контент і безпечно користуватися цифровими сервісами.

Для жертв онлайн-насильства

- Використовувати спеціальні інструменти для повідомлення про загрозливий чи насильницький контент.

- Звертатися до модераторів або незалежних організацій для швидкого вирішення проблеми.

- Шукати підтримку в спеціалізованих організаціях, правозахисних групах або психологічних службах.

Для цифрових платформ

- Запроваджувати системи оцінки ризиків і впливу на права людини та гендерну рівність. Забезпечити, щоб дизайн продуктів і модерація контенту враховували міжнародні стандарти прав людини.

- Публічно повідомляти про політики модерації, алгоритми та обмеження контенту. Пояснювати користувачам причини видалення чи обмеження контенту і надавати можливість для апеляції.

- Забезпечувати ефективну роботу автоматизованих і ручних систем модерації, зокрема перевірку точності та недискримінаційності. Швидко видаляти небезпечний контент.

- Інформувати про стандарти спільноти й процеси апеляції зрозумілою мовою та в доступних форматах.

- Підтримувати інформаційну та медіаграмотність користувачів, зокрема безпечну взаємодію з платформою та критичне оцінювання контенту.

Матеріал підготовлений Texty.org.ua і ГО «Жінки в медіа» в партнерстві з ЮНЕСКО та за підтримки Японії. Автори несуть відповідальність за вибір і викладення фактів, що містяться в матеріалі, а також за висловлені в ньому думки, які не обов’язково збігаються з позицією ЮНЕСКО і не накладають на Організацію жодних зобов’язань.