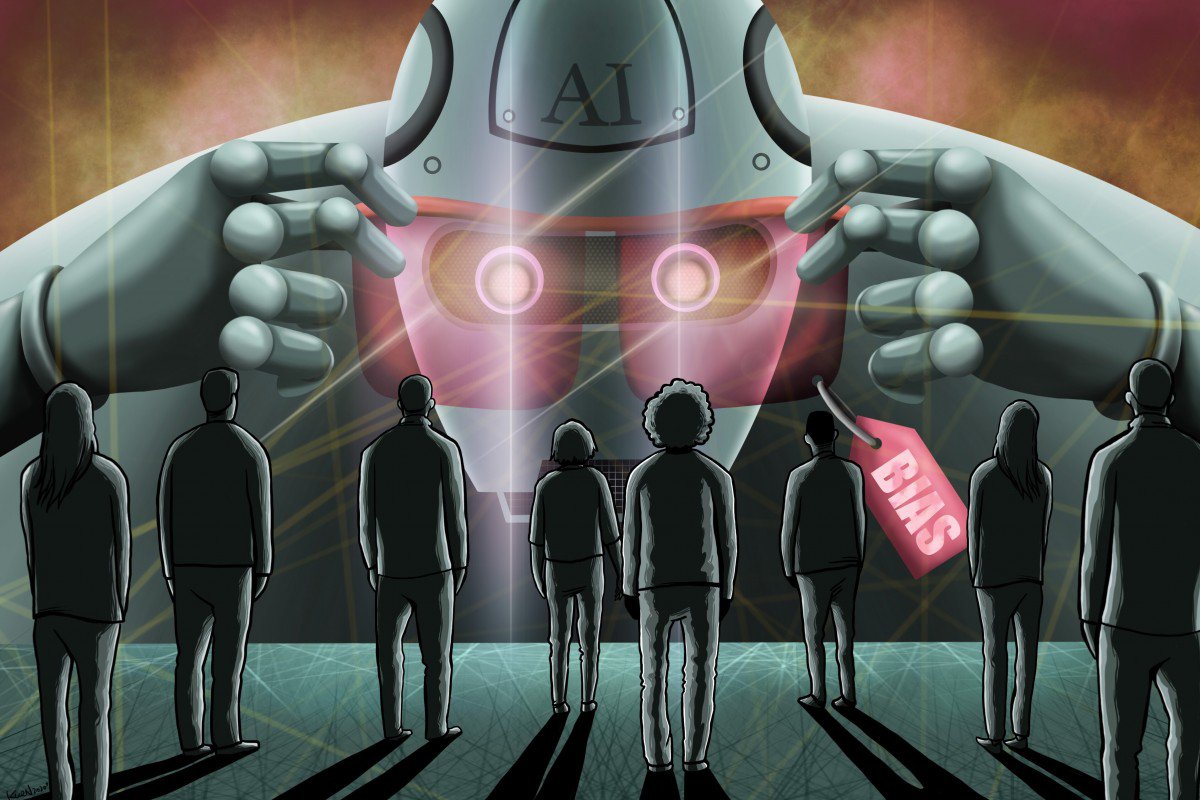

Штучний інтелект буває расистом і сексистом. Але він вже визначає, кого брати на роботу, як лікувати і чи арештовувати

Штучний інтелект залежить від того, хто закладає в нього алгоритми, тому надто часто "робот" – це "привілейований білий чоловік".

Дослідники виявили, що свідомі чи несвідомі людські соціальні упередження можуть посилюватися в алгоритмах штучного інтелекту, котрі визначають доступ до робочих місць, охорони здоров'я, діагностування. Також ці упередження можуть призводити до хибних арештів та навіть смертей, яких можна було уникнути. Наприклад, коронавірус і карантини та соціальне дистанціювання переносять прийом на роботу онлайн. Інструменти для пошуку персоналу, пов'язані зі штучним інтелектом, стають дедалі популярнішими. Проте автоматичне фільтрування кандидатів показує, що упередження можуть відсіяти кваліфікованих кандидатів.

Про це йдеться в матеріалі гонконзької South China Morning Post.

Три роки тому, тестуючи модель штучного інтелекту для автоматичного визначення зображень з інтернету, тодішня аспірантка університету Вірджинії, Чжейю Жао, помітила тенденцію: алгоритм часто визначав людей на кухні як жінок, навіть якщо зображено було чоловіків.

Дослідження, опубліковане у статті 2017 року, шокувало: у зображеннях, які "годували" моделі, жінок на кухні було на 33% більше – однак АІ більш ніж подвоїв цю нерівність.

Штучний інтелект "структурує передбачення" при браку даних – і ризиком при цьому є посилення упереджень, закладених у дані, які давали моделі для навчання.

Але що з того, що машина хибно визначає чоловіка на кухні як жінку, а жінку з пістолетом як чоловіка? А те, що АІ дедалі частіше використовується людьми в усіх сферах – від прийому на роботу й до пошуку злочинців.

Після початку руху Black Lives Matter такі гіганти, як IBM, Microsoft, Amazon заявили, що припиняють продавати програми автоматичного розпізнавання обличчя, оскільки у США виникли побоювання, що ці алгоритми використовуються для расового профайлингу.

"Люди раніше думали, що машина буде справедливіша за людей – однак це неправда", – каже Чжейю Жао.

Голова ради директорів сінгапурської BasisAI пояснює: "Якщо береш дані зі справжнього світу – ці дані вже містять багато упереджень, і системи АІ навчатимуть себе бути упередженими".

99% розробників у світі на даний момент створили алгоритми, які надто часто видають "хибнопозитивні результати" для азіатів: двох різних людей показують як одну, не розрізняючи. Натомість, алгоритми з Китаю мають протилежні проблеми: вони частіше не розрізняють білих людей.

Помилки можуть мати "серйозні наслідки", як от хибне звинувачення у злочині. Люди покладаються на визначення, зроблені комп'ютерами.

Коли в компанії працює більше чоловіків, ніж жінок, то система пошуку працівників може сприйняти наявний баланс як результат, який слід відтворювати – й посилюватиме його.

У медицині вчасний діагноз і лікування можуть мати результатом життя чи смерть – і тут АІ також виявляється "двостороннім мечем".

У медицині історично нехтували біологічною різницею, що пов'язана зі статтю – й відтворення цієї помилки в алгоритмах може вбивати. Наприклад, 40% жінок під час інфаркту не мають болю в грудях, хоча цей симптом вважається "типовим", оскільки базується передусім на чоловіках, у яких інфаркти стаються частіше. Китайські компанії-гіганти вже зараз розробляють АІ, який допомагає діагностувати, наприклад, Covid-19.

Якщо потенційні упередження визнавати – їх можна зменшити, пише видання.

Аудит, проведений у 2019 році, показував, що софт компаній IBM, Microsoft, Megvii після критики покращився: максимальна помилка для темношкірих жіночих облич зменшилася з 34.7% до 16.97%.

Для покращень потрібно, щоб самі люди, які працюють зі штучним інтелектом і мають неусвідомлені упередження, були якомога різноманітніші в усіх розуміннях.

Особлива проблема в усій хай-тек індустрії – значно менша кількість жінок, і це відображається на результатах, які показує штучний інтелект.